Прогнозы по GPT-4

Публичный постПочему это интересно?

Недавно Вастрик понабрасывал идей о современных нейронках, но почти все в контексте их текущего состояния. Хотя с момента появления архитектуры трансформеров (2017), OpenAI почти каждый год выпускает модели на голову лучше предыдущих. И судя по всему это еще не конец.

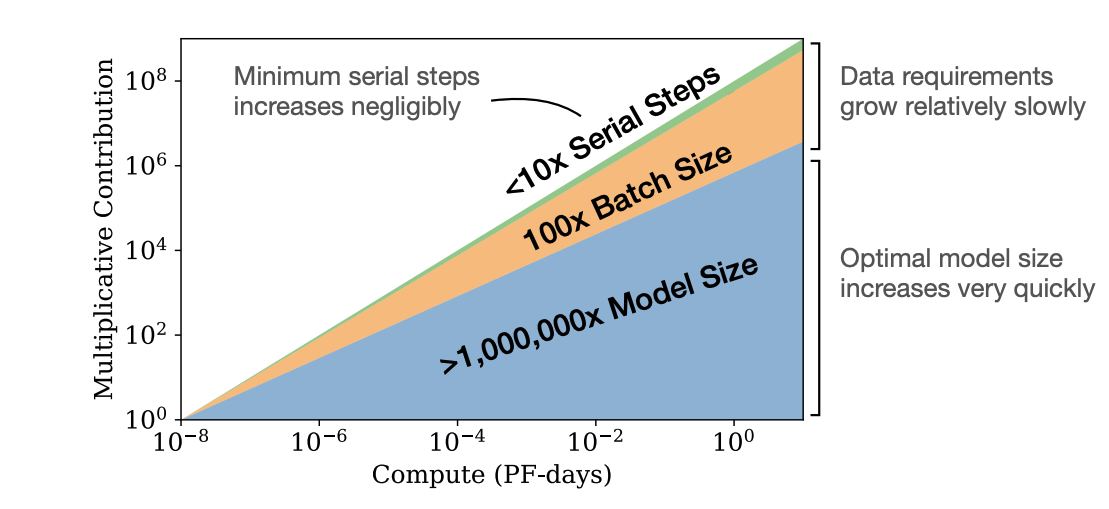

В статье подробное размышление о том, когда выйдет GPT-4 и на что он будет способен. С пруфами! Автор приводит много данных по уже существующим моделям и ссылается на 2 статьи от OpenAI и Deepmind на тему скейлинга.

Какие выводы?

- С ~90% вероятностью GPT-4 выпустят в этом году.

- Это не будет AGI.

- Модель не будет сильно больше GPT-3, но будет на порядок лучше натренирована.

- Сможет удерживать в 2 раза больше контекста (количество токенов).

- И самое важное - модель будет перформить лучше любой из нынешних.

GPT-4 Будет выдавать точность (на определенных задачах), близкую к среднему человеку-эксперту. Для сравнения, GPT 3 немного лучше среднего человека-неэксперта. Улучшение будет не настолько радикальным, как было в случае GPT-2 -> GPT-3.

Чего стоит ожидать?

Мы не знаем, но ..

- Генерация текста на неотличимом от человеческого уровне без редактуры со стороны человека.

- "highly capable at programming" - что то большее, чем просто проходить собесы у Кашницкого или помогать с кодревью. Сейчас чтобы получить рабочий код через ChatGPT, нужно минимум несколько итераций с поиском ошибок и уточнениями.

- Возможнось появления неожиданных свойств. Как например решение задачек или уже упомянуте написание кода.

Что хочу обсудить?

Один из топиков у Вастрика вот про это: "через пару лет все уже за километр будет видеть сгенерированные тексты".

А что, если нет? Представьте мир, в котором ты не можешь доверять никакой информации. И вдобавок нейронки тебя еще и газлайтить будут, лол (чекните пост в Клубе про Bing).

😱 Комментарий удален его автором...

интересно за их развитием наблюдать и волнительно:

Это почему-то напомнило мне о том, что каких-то ~130 лет назад, когда люди впервые увидели записанное на плёнку кино, они в ужасе выбегали из кинотеатра и стреляли в экран из револьверов, потому что думали, что на них едет настоящий поезд.

Ничего не меняется. Мы по прежнему дикие грязные обезьяны, которые удивляются любому новому банану на палочке, и думают «это конец??!!?». Мы духовно ближе к тем реднекам с револьверами в первом кинотеатре, чем хоть к какому-то пониманию процессов и мира вокруг.

А чо его представлять, я УЖЕ БЛЯТЬ В НЁМ ЖИВУ. А вы еще нет?

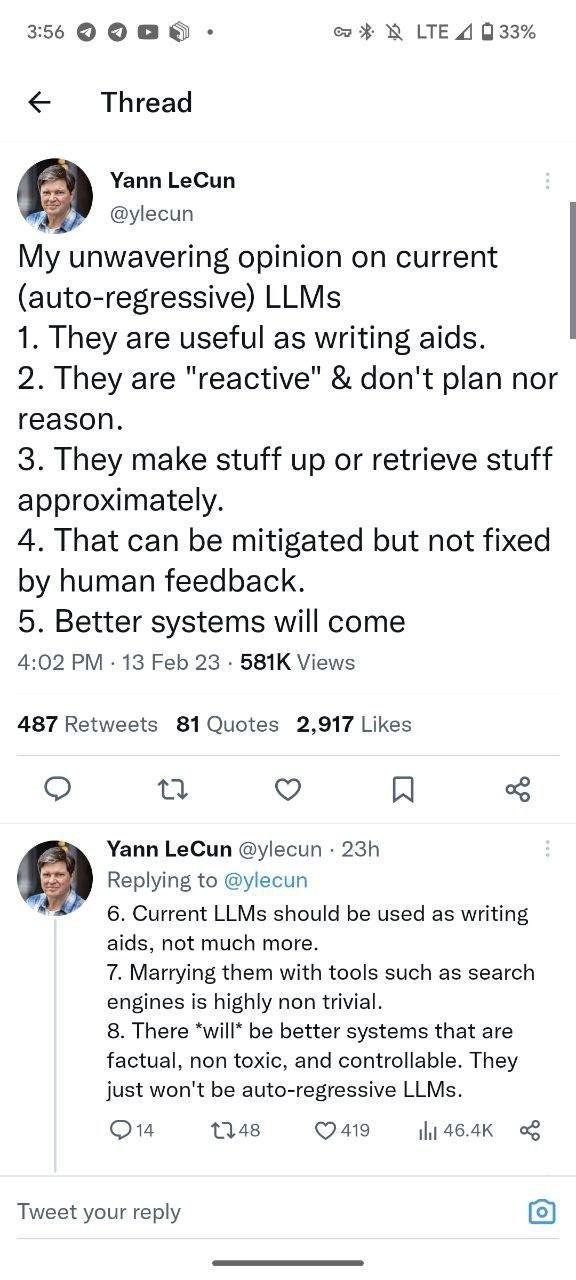

(почти) в тему поста хотел поделиться твитом ЛеКуна про текущую ситуацию в мире LLMок:

Вообще похоже, что авторегрессионные LLMки в итоге упрутся в потолок своей производительности и научное сообщество будет что-то умнее придумывать.

Я тут задавал ему вопросы по деплою в Azure (там был немного нетривиальное ТЗ) и он просто придумал мне флаг --remove-user. ))

Я обрадовался, думал что пропустил этот флаг в доке, потому что он решил бы эту проблему быстро и хорошо, иду в доку и понимаю, что такого флага просто нет для передачи в функцию как параметра, он просто его придумал, тк этот флаг был на поверхности, если следовать просто логике рассуждений «как быстро и хорошо решить проблему».

После этого я спокоен))

😱 Комментарий удален его автором...

будет занятно, если в компах через ~10 лет мы будем ставить вместе с ОС основные нейронки-помощники с датасетом и всю жизнь потом дообучать его под себя.

Меняешь комп - уносишь на новую железку свой личный датасет

@leeaao Всё уже не так радужно:) OpenAI сами же совсем недавно учили сетку классифицировать AI-text от не AI-text. И вот что:

https://openai.com/blog/new-ai-classifier-for-indicating-ai-written-text/

Уже в киберпанке;)

Чат, а посоветуйте, пожалуйста, что можно почитать/посмотреть чтобы поверхностно понимать как это работает под капотом

вакансия в тему

Не уверен про GPT-4, но одна из GPT-X будет уже вне закона. Кожаные мешки задумаются и возьмут тайм-аут. Запомните этот твит.

А вот и релиз

https://openai.com/research/gpt-4