В конце февраля Илон выкатил новую модель. Конечно же "лучшую в мире".

Но так ли это на самом деле?

Как мы уже привыкли, Маск хайпит по полной. Но по факту, в момент релиза объективных данных по модели почти не было. xAI в коротком посте в блоге написали, что это пока бета-версия и модель всё ещё тренируется.

Они показали несколько бенчмарков где Grok 3 всех опережает. И сказали, что доступа к API пока не будет. Это важно, потому что независимые бенчмарки делают свои замеры не вручную, а как раз через API.

То есть, Илон говорит, что Grok-3 "пугающе умён" и превосходит любые существующие модели. Но проверить это можно либо самим пообщавшись с моделью, либо на бенчмарках в посте.

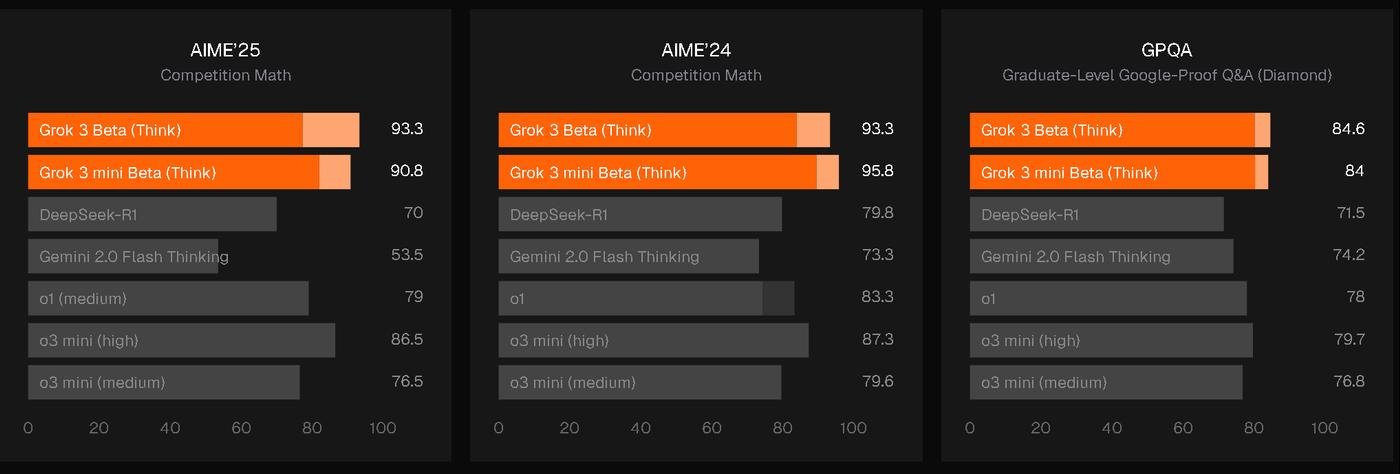

А бенчмарки в посте выглядят вот так:

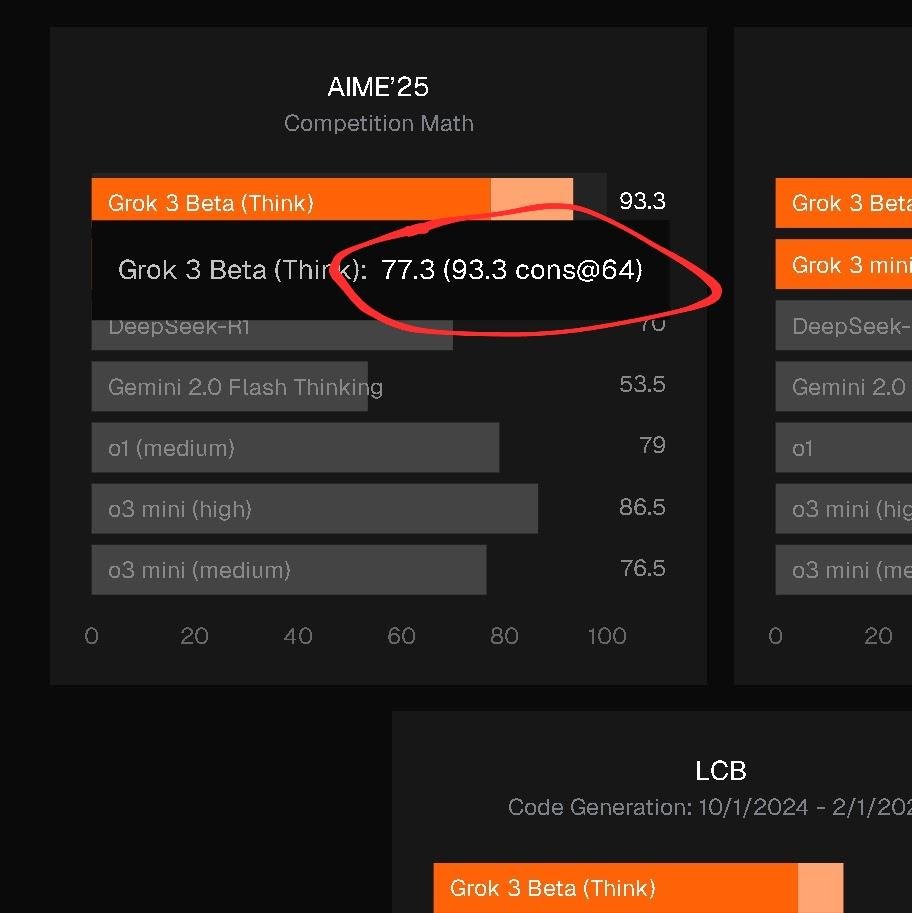

Видите справа область посветлее?

Это прирост результата, когда модели дали сильно больше ресурсов (test-time compute), чтобы отловить более стабильные ответы. Это нечестное сравнение.

Думаю вы знаете, что современные нейронки выдают слегка разные ответы на один и тот же вопрос. Иногда лучше, иногда хуже. Так вот большинство бенчмарков это игнорируют и оценивают только pass@1, то есть первый ответ нейронки на каждый вопрос.

Это проще и больше похоже на то как все привыкли пользоваться нейросетями—мы ожидаем хороший ответ с первого раза.

А все результаты Грока показаны с cons@64. То есть, на каждый вопрос он делал 64 попытки и выбирал ответ, который появлялся чаще всего. И xAI сравнивают результат Грока с приростом с результатами у конкурентов на pass@1.

Короче, с одной стороны заявление, что это некстген модель. А с другой дешёвенькие манипуляции.

В целом я их понимаю: при такой конкуренции все лабы используют хитрости. Просто не так нагло. Например, выбирают только удобные для себя бенчмарки или просто не добавляют в сравнение модели с лучшими результатами.

Ладно, с бенчмарками понятно. А что говорят опытные юзеры после общения с моделю? Консенсус такой:

Модель огромная по размеру, но при этом прорывов она не принесла. Она все еще галлюцинирует и стремится выдавать излишне длинные ответы.

По способностям, Грок-3 где-то на уровне сильнейших моделей OpenAI и чуточку лучше DeepSeek и моделей от Google. Это на момент релиза—спустя два месяца уже вышла Gemini 2.5 и новая GPT-4o.

Но все таки мне дальше есть про что рассказать.

Модель интересная и заслуживает внимания. А Илон и xAI за поразительно короткое время ворвались на рынок и стали одним из основных игроков.

1 - Железо

Самое главное—в 2024 году они построили гигантский вычислительный кластер за рекордно быстрое время. За 4 месяца они запустили 100 тысяч видеокарт Nvidia H100. А потом ещё за 3 месяца удвоили до 200 тысяч карт. CEO Nvidia, Дженсен Хуанг говорил, что на такое обычно уходит 4 года.

Это сложнейшая инженерная задача. И самый крупный датацентр в мире, на этот раз уже без уловок. Никто ещё не смог обьединить столько карт в одном месте.

Как обычно строят такие штуки?

Дефолтный подход—берем несколько стандартных датацентров и обьединяем их в сеть с помощью очень дорогих проводов (Infiniband).

При тренировке модели, датацентрам нужно постоянно обмениваться тоннами данных. И если связь медленная—дорогие видеокарты простаивают, что плохо.

Типичные датацентры—это 10-20 тысяч карт, которые жрут 20-30 мегаватт энергии. Например, у Microsoft (для OpenAI) есть сеть из таких датацентров в Аризоне на 100к карт. А у Меты на 128к.

Видите, тут у Меты рядом два H-образных датацентра.

Требования к питанию для топовых кластеров с 2022 года выросли в 10 раз. Сейчас это примерно 150 мегаватт на кластер. Как небольшой город.

Это сильная нагрузка на электросеть региона. В некоторых штатах производить энергию дешевле, чем доставлять её до места назначения. Потому что не хватает проводов.

Так вот, Илон пришел на этот рынок сильно отстающим. И... сделал "Elon thing". Можно хейтить его твиты, но строить заводы он умеет как боженька.

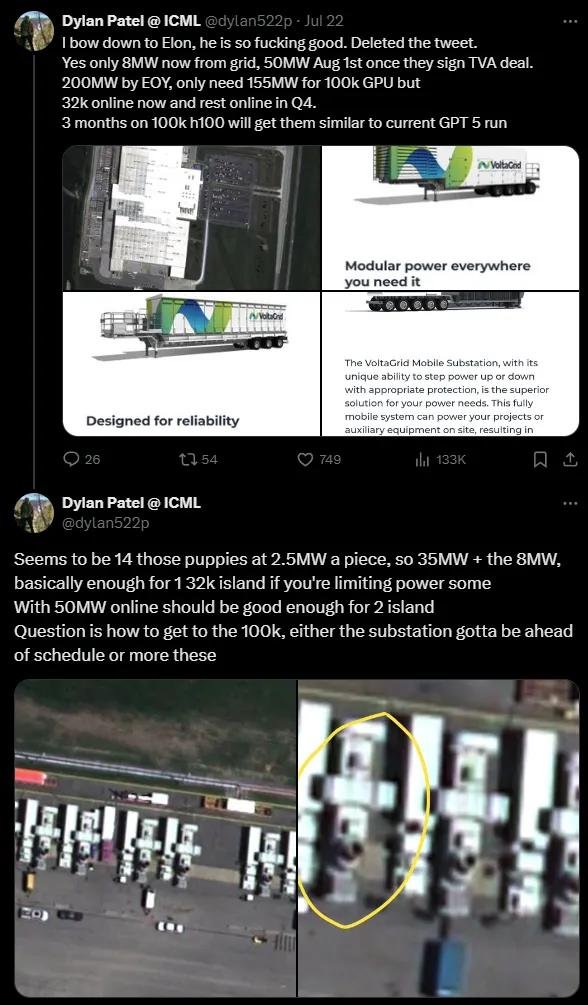

Он купил старую фабрику Electrolux в Мемфисе и решил сделать из нее один огромный датацентр, а не сеть как все остальные. Ожидаемо начались проблемы с энергией.

От местной сети фабрике доставалось всего 7 МВт—этого хватит от силы на 4000 GPU. Местная энергокомпания Tennessee Valley Authority пообещала еще 50 МВт, но к августу. А собственная подстанция xAI на 150 МВт еще строилась и должна была быть готова только к концу года.

Но сидеть и ждать не в стиле Маска.

Дилан Патель (чувак из Semianalysis) по спутниковым снимкам обнаружил, что Маск просто притащил 14 мобильных дизельных генераторов VoltaGrid. Подключил их к 4 мобильным подстанциям и запитал от них датацентр. Буквально привез электричество на огромных трейлерах.

Патель говорил, что они скупили 30% всего американского рынка таких генераторов (но я что то не нашел подтверждение).

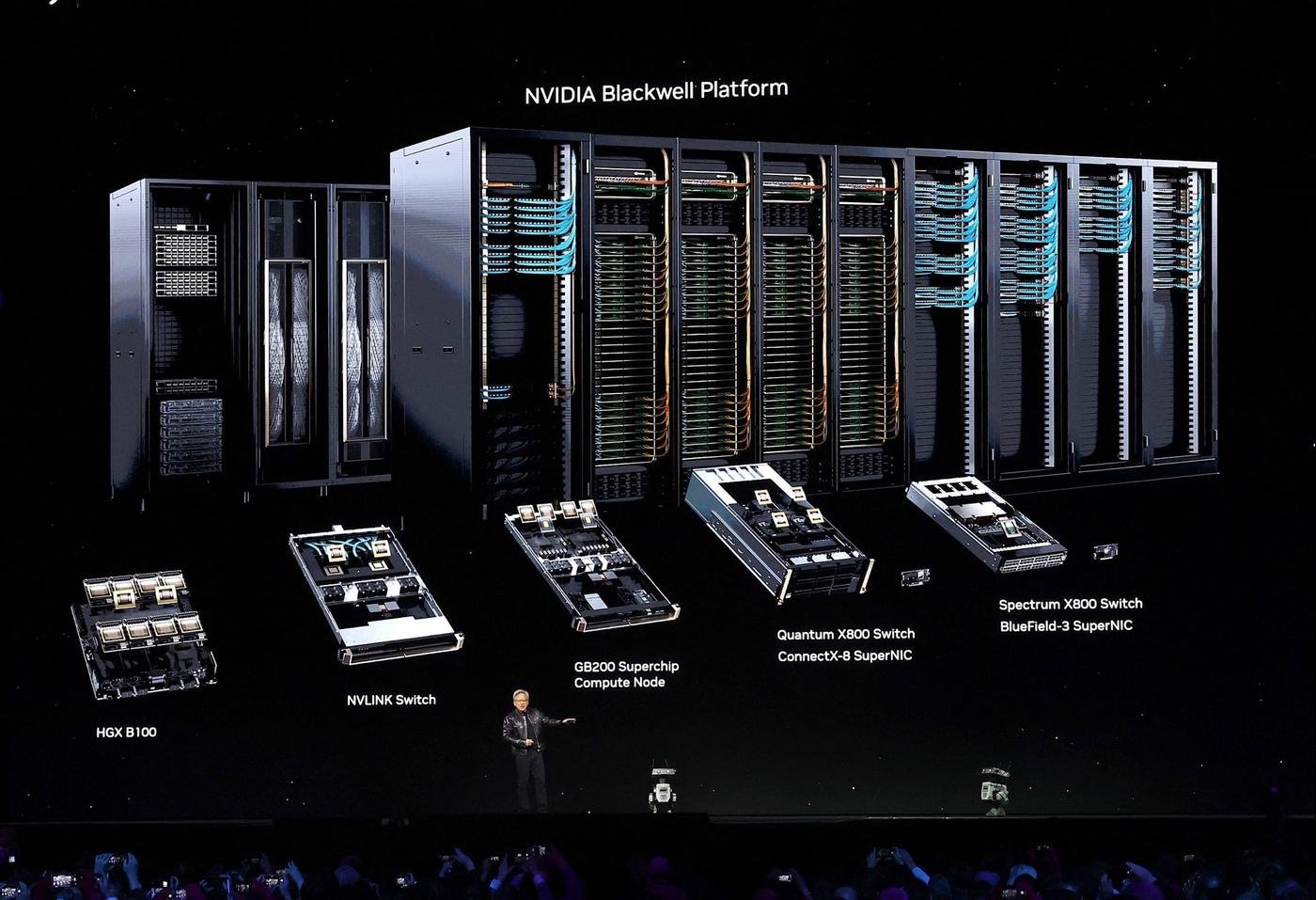

Еще впечатляет, что охлаждение в датацентре водяное. Пока такое в больших масштабах делал только Google. Но это важно: следующие поколения чипов Nvidia Blackwell B200 будут иметь обязательное требование наличия водного охлаждения. То есть всем остальным придётся пересобирать свои датацентры.

Можете глянуть первые пару минут видео, как это все выглядит внутри. Я поржал, с каким энтузиазмом чувак рассказывает про серые коробки, провода и стойки:

Это крутая инженерная система, чего только укладка проводов стоит. Короче, как вывод—никто ранее не выполнял работы такого масштаба за столь короткий срок.

2 - Еще больше железа!

Илон заявил, что к лету 2025 года у компании будет готов кластер из 300к новых Blackwell B200. Если учесть склонность Маска преувеичивать, то вполне реально, что у них будет от 200 до 400к новых чипов к концу 2025.

Насколько B200 круче H100? Цифры плавают в зависимости от задачи, но для обучения моделей (оценка на ноябрь 2024), примерно в 2.2 раза мощнее.

Чтобы запитать такое, Маск планирует построить собственную электростанцию. Причем не абы какую, а на 2.2 ГВт! Это больше, чем потребляет среднего размера город.

Тут он не одинок—все крупные игроки делают что-то похожее:

Meta строит две газовые электростанции в Луизиане.

OpenAI/Microsoft разворачивает аналогичный проект в Техасе.

Amazon и Google тоже строят гигаватные датацентры.

Почему не атомная энергия? Она идеально подходит по мощности, но строить АЭС—это долго. Ты не можешь построить станцию рядом с датацентром даже за год.

Ветряные и солнечные электростанции + аккумуляторы перспективны, но тоже разворачиваются слишком медленно.

В итоге Microsoft и Meta уже пришлось забить на свои "зелёные" обещания по возобновляемой энергии.

Больше конкуренции богу конкуренции!

3 - Grok 3—самая большая модель

Илон построил огромную дорогущую коробку. И что?

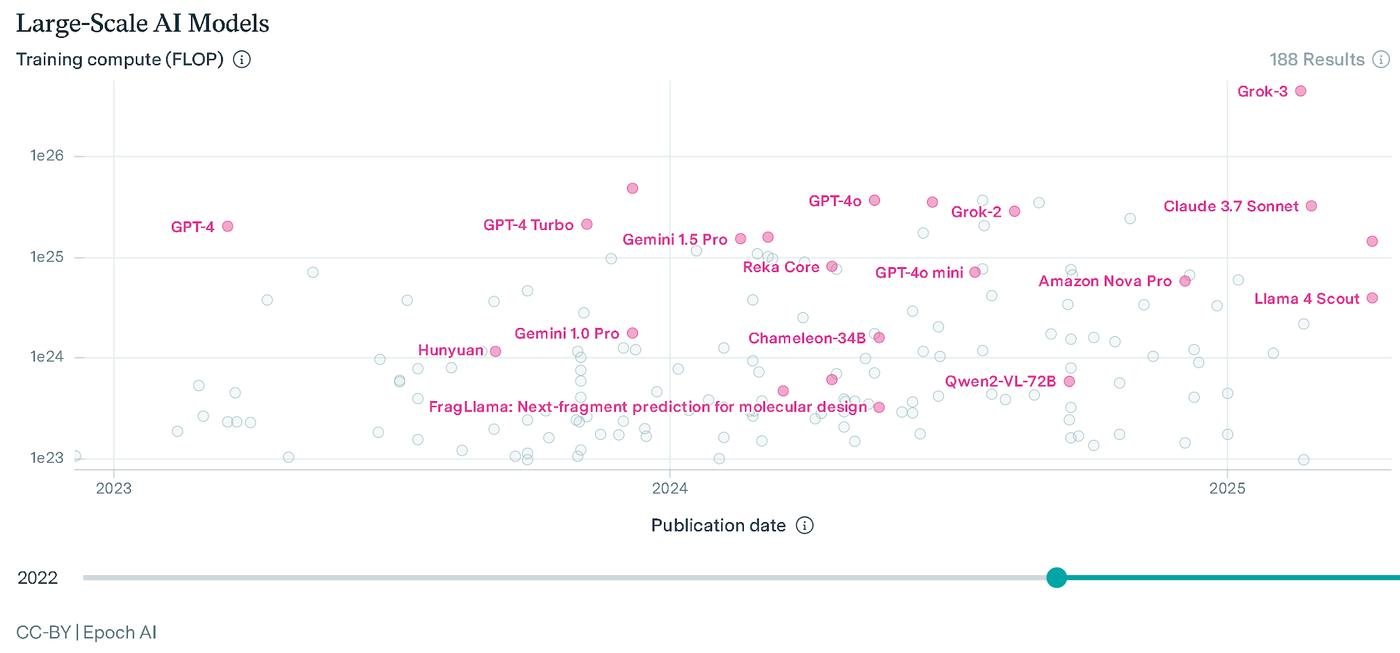

Предположительно, для тренировки Grok 2 использовали ~20к H100 и 100к+ для Grok 3. Для сравнения: GPT-4 тренировали ~90-100 дней на ~25к старых чипов A100. H100 примерно в 2.25 раза мощнее.

То есть, Grok 2 получил вдвое больше ресурсов, чем GPT-4, а Grok 3—ещё в пять раз. Gemini 2.0 от Google скорее всего тренировали на 100к их собственных TPUv6, это примерно столько же железа, но сама модель меньше.

Короче, общие затраты вычислений на Grok 3 на порядок (в 10 раз!) больше, чем у ближайшего преследователя. К сожалению, по GPT-4.5 и Gemini 2.5 данных нет.

И это главный облом. Угрохали кучу денег и ресурсов, построили гига-мега-кластер, а модель получилась просто "на уровне" существующих топов. Точно не сильно лучше.

Экспертиза в обучении LLMок у xAI пока отстает от OpenAI, Google или Anthropic. Они по сути успешно забрутфорсили себе статус одного из лидеров. Но чудес никаких не показали: "Если грубая сила не решает проблему, значит вы используете её недостаточно".

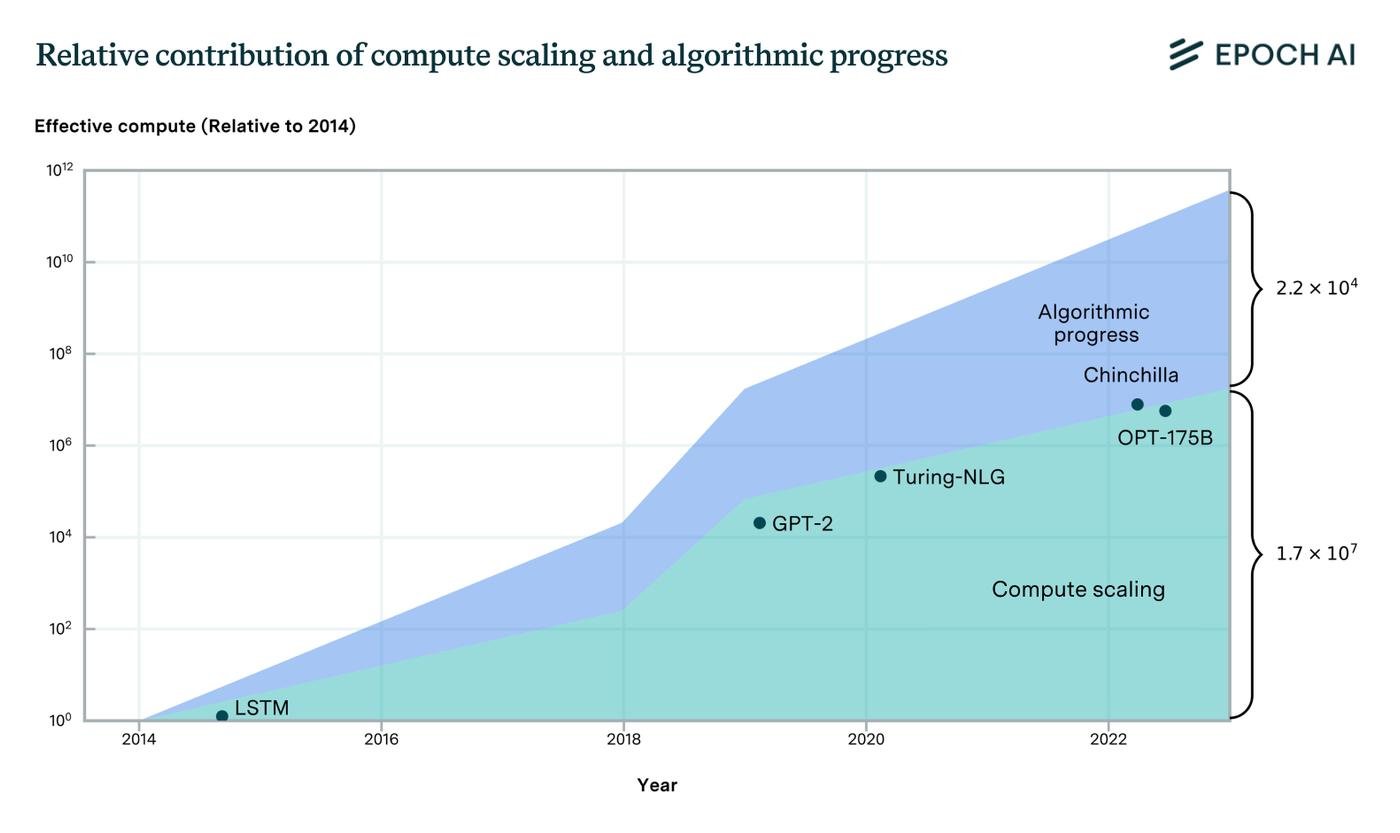

Но тут проблемка. Epoch AI оценили, что за последние 10 лет алгоритмические улучшения внесли примерно треть вклада в рост способностей моделей. И только остальные две-трети внесли уже наращивание железа и размеров моделей.

Брутфорс сработал один раз, но дальше расходы будут расти экспоненциально, принося все меньше отдачи. Поэтому алгоритмическое отставание нужно нагнать. Благо xAI теперь будет проще нанимать крутых ребят в команду, потому что они наконец "двигают фронтир науки".

4 - Чем модель хороша?

1 - Она пока полностью бесплатна (видимо до полного релиза). Без жестких лимитов как у Anthropic, без перебоев как у DeepSeek и без платных моделей у OpenAI.

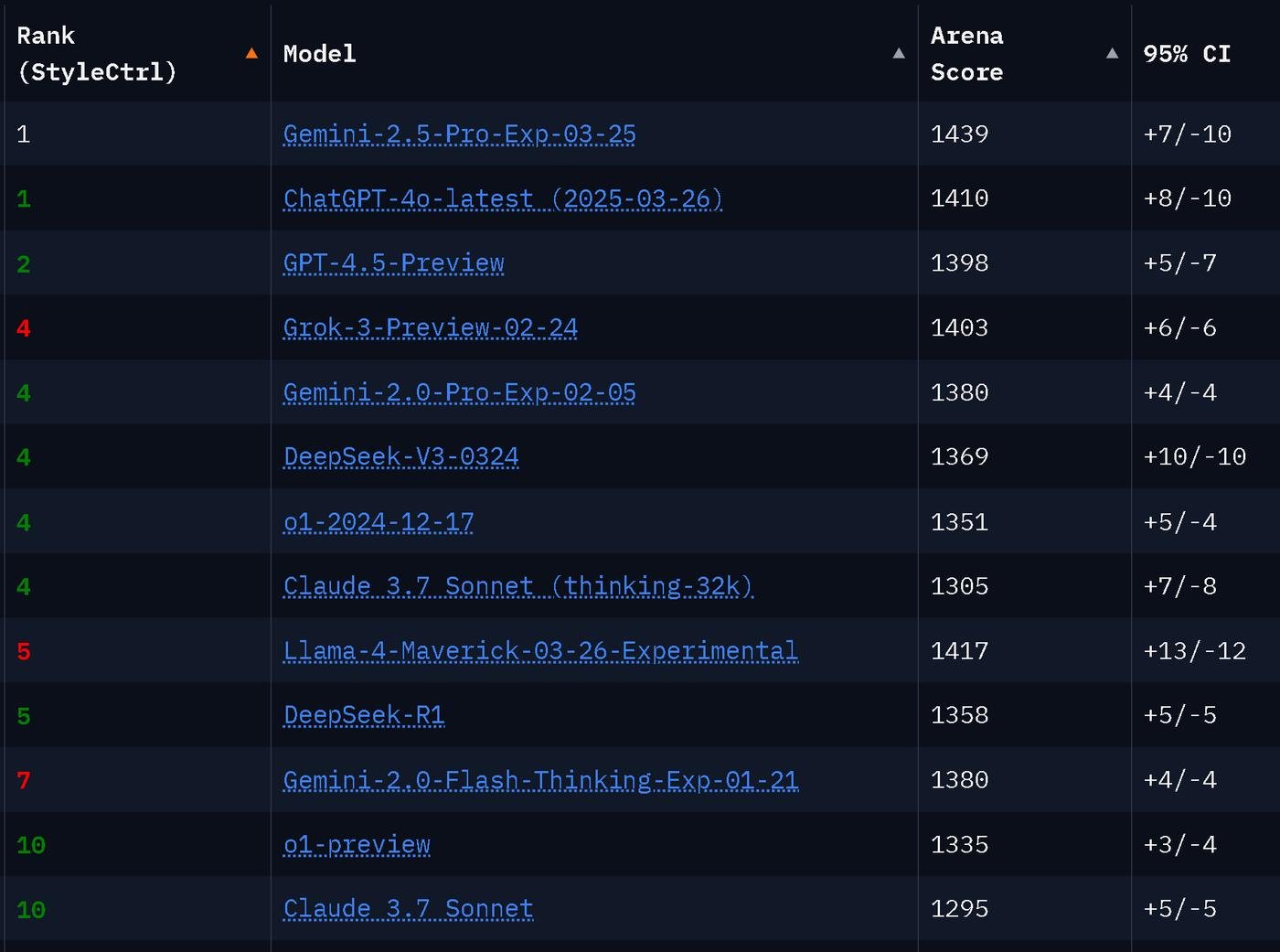

Даже после кучи релизов за последние 2 месяца, Грок держится наверху бенчмарка Арены.

2 - Режим рассуждений и Deep Research, который в феврале был в открытом доступе только у Perplexity и то с большими ограничениями. Сейчас уже Google и OpenAI тоже дали доступ. Возможно благодаря Гроку.

Если не знаете, Deep Research это такой автоматический поиск по сайтам. Он за несколько минут анализирует 30-100 ссылок (у Гугла больше) и дает раздутое самммари, которое остается только быстро фактчекнуть. Это намного проще чем ресерчить с нуля самому. Работает быстрее, чем у остальных, так что я стал пользоваться им для сложного поиска.

3 - Интеграция с Твиттером. Как мне кажется—самая перспективная фича это семантический поиск. То есть ищет по смыслу, а не тупо по ключевым словам.

Можно просить делать саммари постов на какую-то тему, следить за трендами. Хотя пока работает так себе, если честно.

Твиттер хорош тем, что там информация практически в реальном времени. Но Грок пока не успевает за ней и подсовывает данные за последние пару дней, а не за сейчас.

Еще можно просить найти последние публикации в ленте конкретного юзера. Например, чтобы мониторить что в последнее время думают нужные чуваки или компании.

4 - Ну и на закуску, режим 18+.

Грок отлично ломается без особых сложностей и через него можно делать все, что вы зачем то хотите. От секси голоса до рецепта варки мета.

Самый угар—это голосовой режим.

А еще иронично, что Грок не особо хорошего мнения о Маске и Трампе. И когда это всплыло, xAI попытались неуклюже это исправить. Просто захардкодили, что Гроку нельзя ругать Илона. А когда всплыло и это, xAI обвинили во всем бывшего сотрудника OpenAI, который "не впитал культуру компании". Кринж.

Проблема в том, что взгляды Grok—это слепок данных из интернета, а не чья-то злая воля. Менять их сложно, не сломав всю модель.

5 - Пробовать или нет?

Пробовать, но как второго пилота.

TLDR:

Затраты на обучение в разы выше, чем у конкурентов.

И несмотря на это, работает на уровне существующих моделей.

Но модель очень быстрая и бесплатная.

С бесплатным Deep Research режимом, который я рекомендую попробовать, если вы еще не.

Выше уровень галлюцинаций и поспешных выводов.

Текст генерит структурированный, но избыточный и "водянистый".

Интеграция с Твиттером дает доступ к свежей информации.

xAI показали, что могут строить инфраструктуру мирового класса быстрее всех. Но в самих моделях пока догоняют лидеров, заливая отставание деньгами.

Это ещё один сильный игрок, который давит на OpenAI, Google и Anthropic. Конкуренция растет, эксклюзивность топовых моделей тает. И похоже скоро нас ждут ценовые войны за пользователей и коммодитизация AI.

На этом всё, если понравилось, тыкнете апвоут, мне будет приятно. Или напишите комментарий.

Проверить невозможно, но из личных наблюдений: отвечает намного шустрее того же 4o, и галлюцинирует меньше, особенно если надо получать инфу не из англоязычного набора.

Для сравнения, один и тот же вопрос гроку и openai.

В Швеции зеленая карта - это top rope, красная - это lead climbing. OpenAI не только в этом ошибся, но и весь ответ нагаллюцинировал. Грок ответил правильно

Мне понравился бесплатный DeepSearch от грока для выбора товара при покупке. Я перепроверил его пару раз на товарах которые сам раньше выбирал просмотрев кучу обзоров и его рекомендации совпали с тем что в итоге выбрал я.

Обращаюсь к нему, когда остальные модели заходят в тупик. Раскладывает проблему как боженька!

Был бы он встроен в курсор...

Сколько закоммитил илон?

Субъективно, для меня именно грок самая умная модель для запросов типа попиздеть. Подстраивается под манеру промтов - может и матом ругнуться, кекает с моих несмешных шуток. Подмечает подколки и иронию и реагирует на них. Когда я прошу что-то выбрать из товаров, то исключительно по названиям находит характеристики товаров в интернете и аргументировано выкидывает то что не подходит. Правда меня жаба душит платить еще за него. Как грится "у нас есть нейронки дома" - плачу и так за raycast ai

Для кодинга на мой взгляд чуть слабее чем gpt-o1

По делу, спасибо, тыкнула, написала)

Очень интересный пост, спасибо! Тыкаю Грока в телеграмме как премиум юзер - в целом интересно, но есть ощущение что DeepSeek и Minimax (он же Hailuo AI) справляются с моими задачами лучше. Мне нравится разнообразие в инструментах и я, как конечный пользователь, выигрываю от такой конкуренции.

Теперь доступен по API. Наконец-то реальные бенчи.

Сфоткал флакон с инструкцией на чешском. Попросил перевести. Тот грок который в телеге, полностью сгенерил результат. )

Не знаю, насколько адекватная метрика, но Grok 3 -- пока что единственная модель, с которой не возникает желания материться и ПИСАТЬ КАПСОМ, БЛЭТ, чтобы уговорить перестать делать херню