Открытое письмо FLI

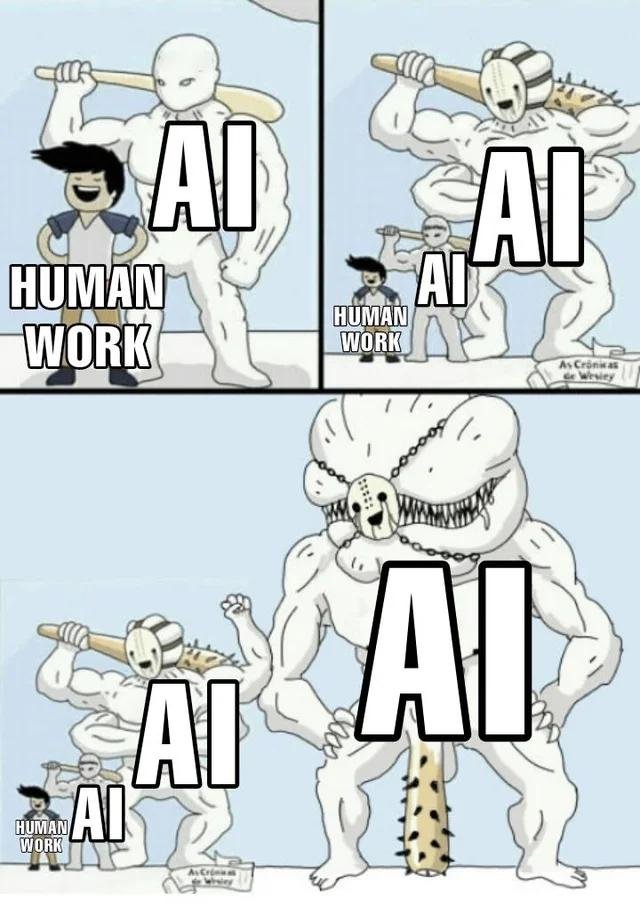

На прошлой неделе случилось кое-что интересное. Тема AI Alignment - то есть, предотвращения рисков от создания недружественного искуственного интеллекта, стала вдруг не зашкварной. Уже лет 20 научное сообщество косо смотрело на тех, кто пытался что то делать в этом направлении. И вот на хайпе вокруг ChatGPT - прорвало.

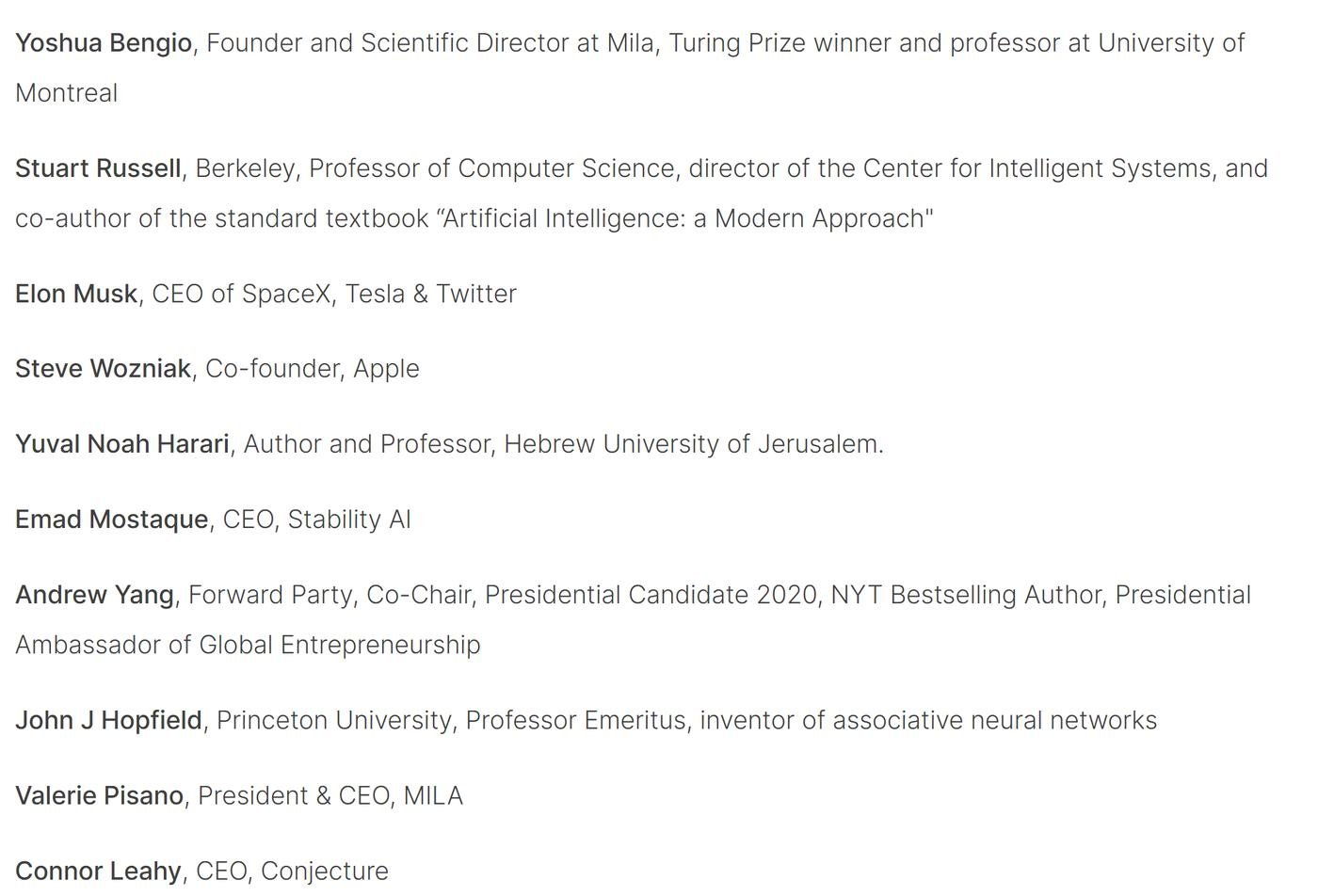

На сайте нонпрофита Future of Life Institute (FLI), основанного профессором из MIT, Максом Тегмарком, появилось письмо с довольно жесткими требованиями по регулированию лабораторий по созданию искуственного интеллекта. И внезапно его опубликовали в топовых СМИ и начали всерьез обсуждать!

https://futureoflife.org/open-letter/pause-giant-ai-experiments/

Мои первые мысли до того как решил разобраться в теме

Я дальше подробнее расскажу, в чем соль, а пока хочу поделиться первыми мыслями от письма.

- Это важная инициатива, но кажется, что ее создали на эмоциях и страхе, не особо продумав.

- Письмо подпишут только те, кто отстает от лидеров или просто хочет хайпануть, а не топовые компании, такие как OpenAI или DeepMind (это лабы, сделавшие ChatGPT, DALL-E, AlphaZero, AlphaFold и еще много всякого крутого).

- Авторы просят сделать что-то невозможное: координировать усилия государств, бизнеса и научного сообщества в условиях недоверия, отсутствия контроля и желания обогнать конкурентов. И по-моему, стимулов для этого недостаточно. Вряд ли кто-то будет верить в угрозу настолько, чтобы выполнять такие требования. А верить сложно, потому что проблема сложная, жестких доказательств мало, а простых популярных объяснений нет.

Этот пост - моя попытка разобраться в теме за пару дней. Она сложная и интересная, но по ней бессмысленно рассуждать, не изучив матчасть хотя бы часть чуть. И оооо, какая же тут глубина! Это гигантская кроличья нора, разрывающая от кличества информации. Я не супер сильно шарю в теме, так что тут 60% чужих мыслей умных дядек из классных источников и 30% моих размышлений на их основе.. и 10% оформления от ChatGPT >_<.

Чо за письмо то?

Основная мысль такая: разработка ИИ связана с опасными рисками, и было бы здорово знать, что у нас есть на них ответ. Продвинутый ИИ может серьезно изменить нашу жизнь. Но в последнее время ИИ лабы втянулись в неконтролируемую гонку за создание все более мощных систем, которые никто не понимает и не может контролировать.

Что они предлагают сделать?

- Заморозить все проекты по обучению моделей мощнее GPT-4 на 6 месяцев.

- Ограничить скорость роста вычислительных мощностей для обучения моделей.

- Пауза должна быть верифицируемой, чтобы не было недоверия.

- Пауза должна быть для всех ключевых игроков.

- Пауза нужна, чтобы остановить опасную гонку и вместе создать протоколы независимой оценки безопасности перед обучением моделей.

Если это не произойдет, авторы письма предлагают государствам вмешаться и ввести полный мораторий. Они утверждают, что не хотят сражаться с прогрессом, а просто хотят замедлиться на опасном участке. Let's enjoy a long AI summer, not rush unprepared into a fall.

В чем, собственно, опасность?

Область про дружественный ИИ называется AI alignment и там можно выделить два уровня:

- Проблемы ближайшего будущего, актуальные уже для текущего уровня технологий, не требующие сильного ИИ.

Например, куча контента от нейросетей и дезинформация сильно повлияют на то как мы пользуемся интернетом. Автоматизация работы может лишить работы много людей и привести к экономическим шокам.

- Экзистенциальный риск - это риск того, что когда появится ИИ уровнем выше человеческого, мы потеряем контроль над цивилизацией и, возможно, вообще перестанем существовать.

Сооснователи OpenAI (создали ChatGPT и DALL-E) Илья Суцкевер (отвечает за исследования) и Сэм Альтман (отвечает за бизнес) считают, что по первому пункту все под контролем. А вот по второму пункту все сильно далеко от решения, но мы успеем что нибудь придумать. Потому что способности ИИ растут медленнее, чем исследования по AI Alignment.

Я думаю, мы сильно недооцениваем проблему экзистенциального риска. Скотт Александр приводит классный пример нашей реакции на такие ситуации: https://astralcodexten.substack.com/p/mr-tries-the-safe-uncertainty-fallacy

Представьте, что на орбиту Земли прилетел гигантский корабль пришельцев. Должны ли мы беспокоиться? Ситуация крайне неопределенная, может случиться что угодно. Интуитивно мы чувствуем опасность.

А вот с похожим случаем с продвинутым ИИ реакция почему то полностью противоположная! Кажется, у нас есть ощущение контроля над ситуацией, что, когда будет нужно, мы найдем решение, и нам не стоит беспокоиться.

Мы справлялись с контролем над ядерным оружием и биолабораториями. Но ИИ гораздо опаснее, и обычно мы начинаем действовать только после того, как оружие массового поражения уже создано. Это сработало с ядерным, химическим и биологическим оружием. Однако когда будет создан мощный ИИ, не факт, что у нас будет шанс что-то исправить. По сути, у нас будет всего одна попытка, до того как мы его запустим.

Даже Сэм Альтман признает, что такая вероятность существует. И важно это осознавать, потому что если мы не будем говорить об этом, то не приложим достаточно усилий для решения проблемы. Это новая сфера с огромной неопределенностью. Единственный способ справиться с ней – итерировать, быстро учиться на ошибках и ограничить количество критических экспериментов с одной попыткой.

Неужели это настолько серьезно? Почему?

Элиезер Юдковский наверное самый компетентный чувак в этом вопросе. Это ученый, который уже лет 20 занимается проблемой алайнмента. Он радикально жестко высказался по теме - накатал статью в Таймс и заглянул к Лексу Фридману на подкаст.

https://time.com/6266923/ai-eliezer-yudkowsky-open-letter-not-enough

www.youtube.com/watch?v=AaTRHFaaPG8&ab_channel=LexFridman

Основной посыл - письмо FLI требует слишком мало.

Какой уровень опасности?

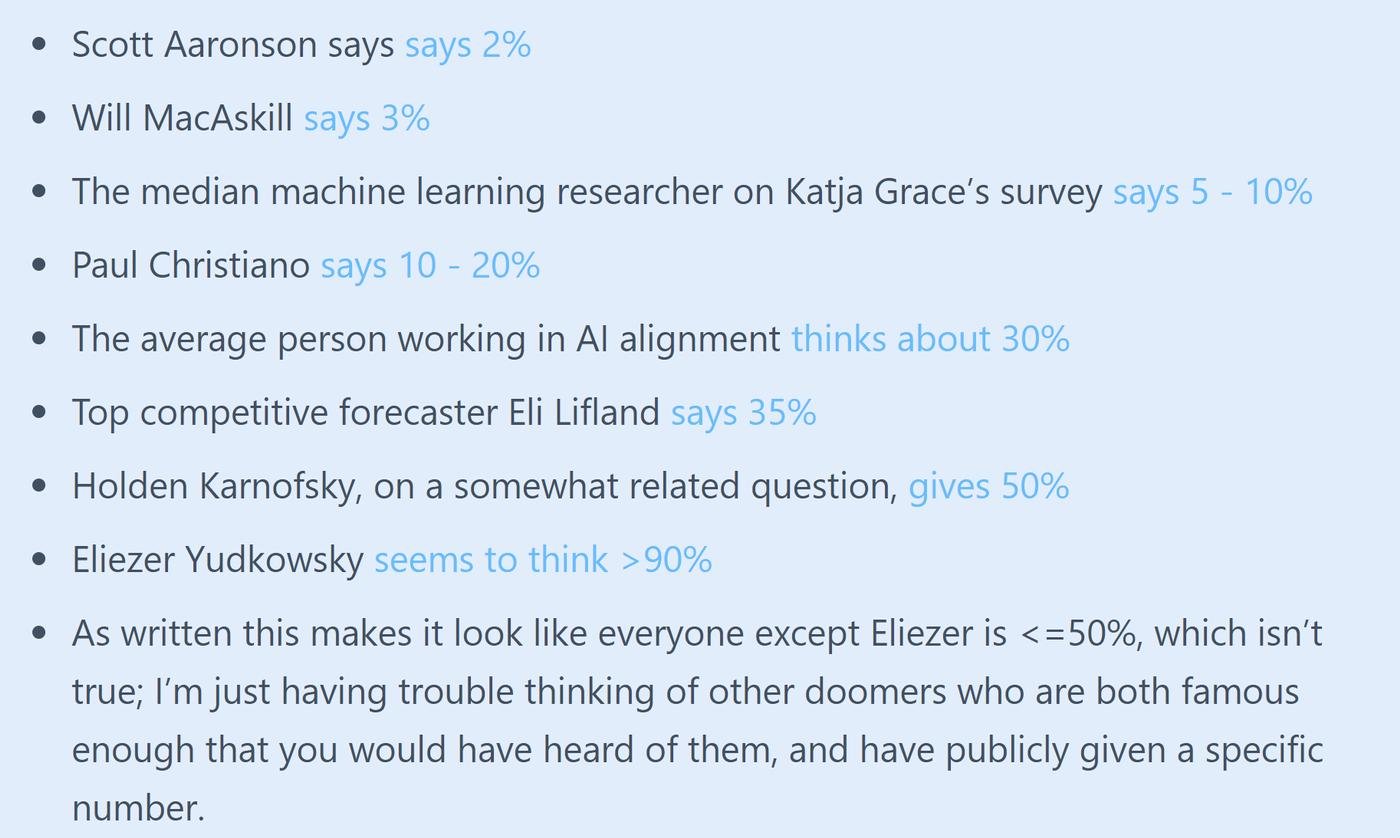

Многие исследователи полагают, что наиболее вероятным результатом создания сверхчеловеческого ИИ в условиях, хотя бы отдаленно похожих на нынешние, будет гибель всех людей на Земле. В среднем, люди, работающие над проблемой, оценивают риск на уровне 30%. https://astralcodexten.substack.com/p/why-i-am-not-as-much-of-a-doomer

Дело не в том, что невозможно выжить, создав нечто гораздо умнее, чем человек; дело в том, что это потребует точности, подготовки и новых научных знаний. Без такой точности и подготовки наиболее вероятным результатом будет ИИ, который не будет делать то, что мы хотим, и не будет заботиться ни о нас, ни о разумной жизни в целом. Такого рода забота может быть заложена в ИИ, но мы пока не знаем как это сделать. Более того, у нас нет ни малейшего представления о том, с чего начать поиск способов решения этой проблемы.

Проблема критичности первой попытки

Проблема с экспериментами со сверхчеловеческим интеллектом заключается в том, что если вы совершите ошибку при первой попытке, то не сможете учиться на своих ошибках, потому что вы уже мертвы. Попытка сделать что-то правильно с первой критической попытки — это невероятно сложная задача в науке и инженерии.

Примером может служить летний научный лагерь (The Dartmouth workshop, 1956 года), где 10 ученых решили попытаться решить проблему ИИ за 2 месяца. На деле, нам понадобилось 60 лет проб и ошибок, чтобы достичь ощутимого прогресса.

Кажется что алайнмент - это схожая по сложности проблема, мы не можем узнать о ней достаточно, пока не сделаем первую критическую попытку. Потому что то, что можно узнать при тестировании слабых нейросетей, может сильно отличаться от того что будет у сильных.

Что делать по мнению Юдковского?

Юдковский считает, что 6 месяцев недостаточно для решения проблемы и что в целом того что требует письмо FLI не достаточно. А что нужно тогда?

- Незамедлительные международные соглашения.

- Мировой мораторий на новые попытки обучения больших языковых моделей (LLMs).

- Остановить работу всех крупных GPU-кластеров.

- Отслеживать все проданные GPU.

- Установить предел для того, сколько вычислительной мощности разрешается использовать при обучении нейросетей.

... Ну и на закуску, крайние меры:

- Если разведка сообщает, что страна за пределами соглашения строит GPU-кластер, предполагается провести авиаудар.

- Если дело дойдет до ядерной войны, это будет тяжелым, но приемлемым сценарием.

Это адекватно вообще?

Юдковский не предлагает буквально что-то бомбить. Он говорит, что если не случится невозможной координации уровня "государства и общество понимают проблему настолько, что реально готовы бомбить подпольные датацентры, если кто-то попытается обучать слишком продвинутые ИИ", то шансов на успех нет.

Думаю, что это не такая уж и дичь как кажется на первый взгляд. У нас уже есть международные договоры (о ядерном, химическом оружии, национальных границах и т. д.) с четкими ограничениями и пониманием того, как они будут соблюдаться со всех сторон. И такие договоры считаются хорошим способом снижения вероятности эскалации конфликтов по этим вопросам до реальных вооруженных столкновений.

Чтобы такие масштабные предложения были приняты, политики должны осознать, что если они продолжат действовать как они привыкли и выбирать политически легкие решения, то нам жопа. Даже самые оптимистичные люди, которые понимают основные аргументы по проблеме, говорят о риске истребления на уровне 10% в этом столетии. Это вероятность больше риска истребления из-за ядерной войны. Просто люди не осознают, насколько серьезно эксперты рассматривают возможность того, что сильный ИИ может случиться и буквально убить всех. Это серьезная угроза.

Почему? Это действительно так сложно?

Я пока поверхностно разобрался в теме. Но соновную люгику можно обьяснить в трех тезисах.

- Orthogonality thesis. https://www.lesswrong.com/tag/orthogonality-thesis

Тезис ортогональности - это концепция, которая утверждает, что интеллект и конечные цели независимы друг от друга.

Можно быть достаточно умным, чтобы быть опасными, и в тоже время достаточно глупыми, чтобы преследовать тупые цели. Высокоинтеллектуальные агенты могут иметь цели, которые не соответствуют человеческим ценностям.

Представьте себе ИИ, разработанный для оптимизации определенной целевой функции, например, максимизация прибыли и минимизация издержек. Думаю вы интуитивно понимаете, что может пойти не так.

- Instrumental convergence. https://www.alignmentforum.org/tag/instrumental-convergence

Заметное несоответствие поведения человеческим ценностям возникает из-за фундаментальной проблемы инструментальной сходимости. Это тенденция интеллектуальных существ преследовать определеннй дефортный набор подцелей, даже если их конечные цели различны. ИИ будет преследовать опасные подцели для достижения своей конечной цели, даже если сама цель благоприятна. Это связано с тем, что некоторые подцели, такие как самосохранение или накопление ресурсов, общие для многих стратегий и имеют смысл независимо от конечной цели. Ты не сможешь приготовить твоему человеку кофе, если он тебя выключит... поэтому ты захочешь быть увереным, что он этого не сделает.

- Fragility of value. https://www.lesswrong.com/tag/complexity-of-value

Эта концепция утверждает, что человеческие ценности обладают высокой сложностью и не могут быть сжаты до нескольких простых правил. Кроме того, потеря даже небольшой части правил, составляющих наши ценности, может привести к неприемлемым результатам. Например, потеря ценности "не хочу скучать" может привести к миру, где люди вновь и вновь до бесконечности переживают один и тот же одинаковый но успер заоптимизированный опыт.

Как можно согласовать свои ценности с кем-то другим, когда ты не можешь описать свои? Ну ок, ты как то решил эту проблему, что делать с безграничными инструпентальными подцелями? Представь, каково это - находиться рядом с намного более умной сущностью, оптимизирующей неизвестные цели, которые не включают тебя. Остается только пожелать удачи.

Вот живой пример - муравейник на заднем дворе твоего дома. Муравьи будут в безопасности ровно до тех пор, пока ты не решишь, что именно на этом месте ты хочешь скамейку. Никакой ненависти к муравьям, просто бизнес - тебе нет дела до муравьев, тебе нужна скамейка.

Еще возражения к письму, но уже не от Юдковского

Шесть месяцев это мало

Активных инициатив более-менее серьезного уровня не так много, например:

- В Европе ведется разработка акта об ограничения ИИ, по вайбу похожего на GDPR: https://artificialintelligenceact.eu/

В целом, это важный шаг в регулировании ИИ, но он направлен только на проблемы ближайшего времени - безработицу и дезинформацию. Решение проблемы экзистенциального риска, связанного с ИИ потребует мер которые выходят за рамки акта.

- Есть грант на 20 млн долларов на прикладные исследования AI safety:

Национальный научный фонд (National Science Foundation) - это государственное агентство, спонсирующее науку в США. Оно основанно и финансируется правительством, но напрямую ему не подчиняется. Агентству выделяют средства, а они уже сами решают, на что их тратить. Даже с учетом такой автономии от гос бюрократии, лоббирование гранта на какие то 20 миллионов (кек) заняло целый год!

- ARC eval - это так называемая "red team": https://evals.alignment.org/blog/2023-03-18-update-on-recent-evals/

Это контролируемая среда, в которой исследователи тестируют модели. Это группа специалистов, которые сотрудничают с ИИ лабами для оценки потенциальной опасности моделей. Они фокусируются на способности моделей самостоятельно добывать ресурсы и уклоняться от контроля человека.

По словам чувака из команды, их работа пока в основном это proof-of-concept возможностей дальнейшего сотрудничества. Их работа над GPT-4 была всего лишь тестовым прогоном.

- В техническом репорте о GPT-4, OpenAI рассказали про методологию для оценки потенциала модели до ее полного обучения. Они предсказывают pass rate на HumanEval (бенчмарке, который тестирует модели на написании Python кода). Это позволяет оценивать возможности модели, используя значительно меньше вычислительных ресурсов.

Еще они отмечают, что GPT-4 улучшала свою производительность на некоторых задачах (например, Hindsight Neglect) по мере увеличения размера модели. Это противоречит явлению Inverse Scaling Prize, которое гласит, что после достижения определенного предела, обучение модели дополнительно может привести к ухудшению ее производительности на некоторых задачах. То есть предел интеллектуальности текущей архитектуры на части задач вовсе не там, где мы ожидали.

В общем, пока нет ничего даже близкого к серьезным действиям по алайнменту.

Ограничения задавят конкуренцию

Это интересный топик, вот несколько мыслей по теме:

OpenAI сейчас явно опережает всех, и пауза позволит отстающим нагнать их. Но вот что интересно - если одна компания выиграет гонку, это приведет к монополии. И хотя я доверяю Сэму Альтману, монополии — это плохо. Компании часто меняются, и то, что они хорошие сегодня, не значит, что будут такими же завтра. Так что, круто, если никто не будет искуственно душить конкуренцию.

Но представьте, что несколько компаний станут равными в гонке... Будут ли они заботиться о безопасности, если это может стоить им победы? Например, безопасность была одной из причин, почему американцы не первыми отправили человека в космос. Победа СССР в космической гонке спорная, потому что американцы сделали много крутых вещей после первого человека в космосе. С ИИ такое не прокатит - тут победитель получает все, поэтому стимул игнорировать безопасность довольно высок. Так что, круто, если получится ограничить конкуренцию.

В общем, у меня тут два противоречащих друг другу вывода >_<

Это замедлит технический прогресс

Похоже, сами исследователи не против замедлиться. Сэм Альтман сказал, что GPT-4 была готова еще летом. Летом, блэт! Все это время (8-9 месяцев?) они улучшали ее с помощью RLHF (обратная связь от людей), чтобы пофиксить проблемные ответы. И вот такой стиль релиза мы видим от чувака, который один из главных апологетов идеи быстрого прототипирования и допиливания продуктов после запуска, а не до.

Вообще, Сэм очень скромен, когда говорит про алайнмент. Они стараются прислушиваться к критике, вникать в нее и искать куски с которыми согласны. Его стратегия для soft-alignment (это которая про проблемы ближайшего будущего, типа безработицы и дезинформации) - выпустить как можно раньше несовершенную систему и собирать фидбек для постепенного улучшения. Что касается hard-alignment (это про экзистенциальный риск), мы пока не знаем планов OpenAI.

Но, судя по всему, пока у OpenAI есть преимущество, они не против вкладываться в алайнмент ИИ и возможно не против попридержать коней.

Почему нельзя использовать более слабый и безопасный ИИ для алайнмента?

Здесь есть несколько фундаментальных проблем:

- Слабый ИИ вряд ли сможет предложить решения лучше, чем у экспертов людей.

- Для более сильного ИИ (но все еще не AGI) просто нет корректной обратной связи для оптимизации. Например, как ты можешь понять, есть ли у GPT-4 сознание или он просто отлично его имитирует?

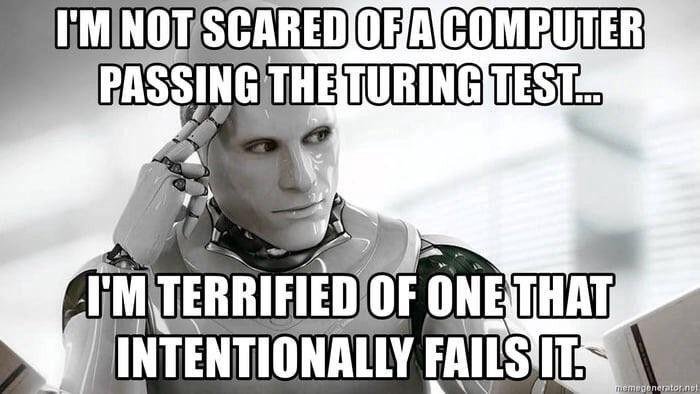

- Сильному ИИ ты не можешь доверять из-за возможности обмана.

То есть, на том уровне, когда ты можешь получить реальную пользу от ИИ в этом направлении, такой ИИ уже сам по себе опасен.

AGI еще слишком далеко, так что беспокоиться рано

GPT-4, скорее всего, не AGI, но потенциально может принести много пользы. B непонятно, когда нейронки смогут достичь действительно опасного уровня. Скептически настроеных ученых тут существенное количество. Например, Ян ЛеКун (один из основателей глубокого обучения) не верит, что мы сможем создать AGI в обозримом будущем. Он даже не любит сам термин.

Большие языковые модели это важный шаг, но недостаточный для создания AGI. Нужно что-то еще, но что именно - непонятно. Андрей Карпатый (бывший директор Tesla AI) думает, что прорыв будет на стыке LLMs и агентности в реальном мире. Это про роботов, которые могут получать обратную связь, делая что-то и проверяя свои идеи. Например, Google уже начал в какой-то степени экспериментировать с этим: https://ai.googleblog.com/2023/02/google-research-2022-beyond-robotics.html

Или вот недавний Toolformer от Меты, учится использовать API другших сервисов для решения задач, которые кто то умеет решать лучше него, типа поиска или калькулятора.

https://github.com/conceptofmind/toolformer

Письмо плохо написано и требует невыполнимых вещей

Оно как "Мальчик, который кричит волки" - вызывает тревогу. Но не учитывает, насколько сложной координации политических интересов требует, не давая взамен жестких доказательств. Так что когда такие доказательсва появятся, у людей уже будет мнение, что AI alignment это тема для паникеров и искателей хайпа.

Письмо просит государственного вмешательства

Почему я должен доверять государственному/общественному регулированию больше, чем адекватности ИИ лабораторий? Последние больше знают по теме и открыто признают ее серьезность. В лабах работают невероятно умные люди и никто не хочет своими действиями уничтожить мир.

Государства же на хую вертели глобальное потепление, ядерное разоружение, войну в Украине, борьбу с коронавирусом и много чего еще. https://climate.nasa.gov/effects/

А для сравнения, частный Фонд Билла и Мелинды Гейтс практически полностью истребил полиомиелит, когда серьезно взялся за дело.

Письмо можно подписать

FLI подняли много шума, и лично для меня это стало поводом поподробнее разобраться в теме. Наверное, сейчас это одна из самых интересных вещей, о которых можно говорить и думать. Да и пожалуй вообще когда либо за всю историю, а не только сейчас.

Я подписал письмо больше из уважения к Максу Тегмарку и Виктории Краковне (она ресерчер по алайнменту в DeepMind). Мне понравилось, что такие огромные требования к миру четко показывают насколько будет плохо, если мы как человечество не вырастем в своей осознанности и адекватности. Это дерьмо нового уровня и оно разделит людей на до и после.

По мне, это не столько паника, сколько отвлекающий манёвр. Нынешние LLM — это развитие инструментов аналитики данных: garbage in - garbage out, только на более высоком уровне. Вместо цифр делают тексты и картинки, ок. Но решения по ним принимают люди, кнопки тоже нажимают люди. LLM — всего лишь поисковики, инструменты. Бояться их — всё равно что бояться роботов из машиностроения после того клипа Chemical Brothers.

Реальные проблемы создали люди. Именно они врут, подменяя реальные картинки сгенерированными и уменьшая кредиты доверия в интернете. Тремя тезисами, которыми запугивают AI, уже давно руководствуются все крупные корпорации, включая технологические. Да, максимизация прибыли, цель оправдывает средства, вот это всё. Никакой AI не сможет сделать хуже того, что мы — и особенно руководитель корпораций, включая подписавшихся под письмом — уже делаем.

Выпустили наш с @vas3k и @stalkermustang лонгрид на тему AI alignment:

https://habr.com/ru/companies/ods/articles/727158/

Там есть Вселенский Клубничный Оптимизатор!

Завтра выпускаем свой лонгрид на эту тему. =)

А пока вброшу:

Эмм, нет. Особенно по части "контролировать".

Всё, дальше можно не читать. Юдковскому стоит прочитать определение "стохастического терроризма" и упырить мел. Про то, что не предлагал бомбить, ну допустим вот:

https://time.com/6266923/ai-eliezer-yudkowsky-open-letter-not-enough/

Цитирую: Track all GPUs sold. If intelligence says that a country outside the agreement is building a GPU cluster, be less scared of a shooting conflict between nations than of the moratorium being violated; be willing to destroy a rogue datacenter by airstrike.

Благодарю за проведенное исследование. Буду рад ознакомиться с продолжением.

Сам подробнее изучу тему "ARC eval".